-

Die

vorliegende Erfindung bezieht sich allgemein auf Rechnersysteme

und insbesondere auf ein Verfahren und eine Vorrichtung zur dynamischen

und konsistenten Namensgebung von strukturgebundenem Speicher.

-

Technologische

Evolution resultiert häufig

aus einer Reihe scheinbar nicht zusammenhängender technischer Entwicklungen.

Obwohl diese nicht zusammenhängenden

Entwicklungen jeweils für

sich bedeutend sein können,

können

sie kombiniert das Fundament einer wichtigen technologischen Evolution

bilden. Historisch gesehen ist das technologische Wachstum von Komponenten

in großen

komplexen Rechnersystemen ungleichmäßig verlaufen, einschließlich beispielsweise

(1) der im Vergleich zum Leistungsvermögen der Festplatteneingabe/-ausgabe

rasante Fortschritt beim CPU-Leistungsvermögen, (2) der Entwicklung interner CPU-Architekturen

und (3) von Verbindungsstrukturen.

-

Dokument

US-A-5 671 441 bezieht sich auf Verfahren zur automatischen Identifizierung

von I/O-Komponenten. Dokument EP-A-0 365 115 offenbart einen Identifizierungsgenerator,

der eine eindeutige Identifizierung für Objekte in einem verteilten

Computersystem erzeugt. Dokument US-A-5 303 383 offenbart, wie Schaltknoten

verbunden werden, um ein Netzwerk zu implementieren.

-

Im

Verlauf der letzten zehn Jahre ist das Leistungsvermögen der

Festplatteneingabe/-ausgabe insgesamt sehr viel langsamer angewachsen

als das des Netzknotens. Das CPU-Leistungsvermögen wurde mit einer Geschwindigkeit

von jährlich

40 bis 100 % pro Jahr erhöht,

während

sich die Festplattensuchzeiten lediglich um 7 % jährlich verbessert

haben. Wenn sich dieser Trend erwartungsgemäß fortsetzt, wächst die

Anzahl von Festplattenlaufwerken, die ein typischer Serverknoten

betreiben kann, soweit an, dass die Festplattenlauf werke in den

meisten großen

Systemen zu einer dominierenden Komponente sowohl in Bezug auf Quantität als auch

Wert werden. Dieses Phänomen

hat sich bereits in bestehenden Großsystemanlagen bemerkbar gemacht.

-

Ungleiche

Leistungsstaffelung tritt auch innerhalb der CPU auf. Um das CPU-Leistungsvermögen zu verbessern,

haben CPU-Anbieter

eine Kombination von höheren

Taktgeschwindigkeiten und Architekturänderungen angewendet. Bei vielen

dieser Architekturänderungen

handelt es sich um erprobte Technologien, die aus dem Bereich der

Parallelverarbeitung wirksam eingesetzt wurden. Diese Änderungen

können

ein unausgeglichenes Leistungsvermögen verursachen, was zu einer

Steigerung des Leistungsvermögens

führt,

die nicht so hoch wie erwartet ausfällt. Ein einfaches Beispiel:

Die Grundbefehle ändern

sich nicht mit derselben Rate wie die Geschwindigkeit, mit der eine

CPU Interrupts vektorisieren kann. Somit ändern sich Systemfunktionen,

die vom Interrupt-Leistungsvermögen

(wie beispielsweise Eingabe/Ausgabe, E/A) abhängig sind, nicht auf gleiche

Weise mit der Rechnerleistung.

-

Auch

Verbindungsstrukturen zeigen ungleiche Charakteristika in Bezug

auf das Technologiewachstum auf. Jahrelang befand sich ihr Leistungsniveau

in einem Bereich von 10 – 20

MB/Sek. Im letzten Jahr traten dann auch hier erhebliche Sprünge in Bezug

auf die Bandbreite auf ein Niveau von 100 MB/Sek. (und mehr) auf.

Dieser große

Leistungszuwachs ermöglicht

die wirtschaftliche Entwicklung von Systemen mit massiver Parallelverarbeitung.

-

Dieses

ungleichmäßige Leistungsvermögen wirkt

sich auf Anwendungsarchitekturen und Systemkonfigurationsoptionen

negativ aus. In Bezug auf das Leistungsvermögen von Anwendungen beispielsweise

werden Versuche, die Arbeitslast zu erhöhen, um dadurch die Verbesserung

des Leistungsvermögens

in einem Teil des Systems, wie beispielsweise ein erhöhtes CPU-Leistungsvermögen, vorteilhaft

auszunutzen, oftmals durch den Mangel an einer äquivalenten Verbesserung des

Leistungsvermögens

im Festplattenteilsystem erschwert. Während die CPU die doppelte

Anzahl an Transaktionen pro Sekunde erstellen könnte, kann das Festplattenteilsystem

nur einen Bruchteil dieser Erhöhung

verarbeiten. Die CPU wartet ständig

auf das Speichersystem. Der Gesamteffekt eines ungleichen Wachstums

des Hardwareleistungsvermögens

besteht darin, dass das Leistungsvermögen von Anwendungen eine zunehmende

Abhängigkeit

von den Eigenschaften bestimmter Arbeitslasten erfährt.

-

Ungleichmäßiges Wachstum

bei den Plattformhardwaretechnologien kann ebenfalls in anderen schwerwiegenden

Problemen resultieren: einer Verringerung der Anzahl verfügbarer Optionen

zur Konfigurierung von Mehrknotensystemen. Ein gutes Beispiel ist

die Art und Weise, auf die die Softwarearchitektur einer TERADATA®-Vierknoten-Clique

durch Änderungen

der Technologie der Speicherverbindungen beeinflusst wird. Das TERADATA®-Cliquenmodell

erwartet eine einheitliche Speicherkonnektivität zwischen den Knoten in einer

einzigen Clique: Von jedem Knoten aus kann auf jede Festplatte zugegriffen

werden. Wenn ein Knoten ausfällt,

kann daher der diesem Knoten zugeordnete Speicher auf die übrigen Knoten

aufgeteilt werden. Das ungleichmäßige Wachstum

bei der Speicher- und der Knotentechnologie schränkt die Anzahl an Festplatten ein,

die pro Knoten in einer Umgebung mit geteiltem Speicher angeschlossen

werden können.

Diese Einschränkung

entsteht aus der Anzahl an Festplattenlaufwerken, die an einen E/A-Kanal

angeschlossen werden können,

und der physischen Anzahl an Bussen, die in einer E/A-Topologie

mit Aufteilung auf vier Knoten angeschlossen werden können. Aufgrund

der zunehmenden Verbesserung des Leistungsvermögens der Knoten muss die Anzahl

an Festplattenspindeln, die pro Knoten angeschlossen werden, erhöht werden,

um die Leistungssteigerung umzusetzen.

-

Gestaltungen

mit Clustern und massiver Parallelverarbeitung (massively parallel

processing, MPP) sind Beispiele von Gestaltungen von Mehrknotensystemen,

die die vorhergehenden Probleme zu lösen versuchen. Cluster leiden

unter begrenzter Erweiterbarkeit, während die MPP-Systeme zusätzliche

Software erfordern, um ein ausreichend einfaches Anwendungsmodell

zu bieten (in handelsüblichen

MPP-Systemen handelt es sich bei dieser Software für gewöhnlich um

ein Datenbankverwaltungssystem). MPP-Systeme benötigen außerdem eine Form interner Clusteringbildung

(Cliquen), um eine sehr hohe Verfügbarkeit bereitzustellen. Beide

Lösungen

resultieren noch immer in Herausforderungen in Bezug auf die Verwaltung

der potentiell großen

Anzahl an Festplattenlaufwerken, die als elektromechanische Einrichtungen

ziemlich vorhersagbare Ausfallraten auf-weisen. Die Probleme bei

der Knotenverbindung werden in MPP-Systemen verschlimmert, da die Anzahl

an Knoten für

gewöhnlich

viel größer ist.

Beide Ansätze

resultieren außerdem

in Herausforderungen in Bezug auf die Festplattenkonnektivität, die erneut

durch die große

Anzahl an Festplatten, die zum Speichern sehr großer Datenbanken

erforderlich sind, verstärkt

werden.

-

Die

großen

Datenverarbeitungssysteme, die oben beschrieben wurden, stellen

für eine

Fehlertoleranz und Datensicherheit eine vergrößerte Redundanz bereit. Derartige

Systeme erfordern jedoch einen ortsunabhängigen Namensdienst für strukturgebundenen

Speicher und einen, der mit bestehenden Datenbank API's kompatibel ist,

die begrenzte Bitlängennamen

sind.

-

Es

ist eine Aufgabe der vorliegenden Erfindung, den obigen Nachteilen

zu begegnen.

-

Die

vorliegende Erfindung stellt ein Verfahren gemäß dem beigefügten Anspruch

1, eine Vorrichtung gemäß dem Anspruch

3, eine Programmspeichereinrichtung und ein Parallel verarbeitungssystem

gemäß den Anspruchen

5 und 7 bereit.

-

Die

vorliegende Erfindung stellt ein Parallelverarbeitungssystem bereit.

Das System umfasst eine Vielzahl von Computerknoten zum Ausführen von

Anwendungen über

eine Speicheranwendungs-Programmierungs-Schnittstelle, die System-Eingang/Ausgang-Aufrufe

aufweisen, eine Vielzahl von I/O-Knoten

und ein Dateisystem, das auf dem Computerknoten implementiert ist,

zur Speicherung von Informationen, die API-System-Eingang/Ausgang-Aufrufe

für das

Datenobjekt mit der global eindeutigen Identifizierung für das Datenobjekt

zuordnen. Jeder I/O-Knoten managt eine kommunizierend verbundene

Vielzahl von Speicherressourcen und jeder weist ein Mittel zur Erzeugung

einer global eindeutigen Identifizierung für ein Datenobjekt auf, das auf

der Speicherressource gespeichert ist, und überträgt die global eindeutige Identifizierung

und das Datenobjekt über

mindestens eine verbindende Struktur, die eine Kommunikation zwischen

jedem der Computerknoten und jedem der I/O-Knoten bereitstellt,

zu dem Computerknoten.

-

1 ein

Blockschema der obersten Ebene einer Ausführungsform der vorliegenden

Erfindung, das die Architektur-Hauptelemente

zeigt;

-

2 ein

Blockschema des Systems einer Ausführungsform der vorliegenden

Erfindung;

-

3 ein

Blockschema, das die Struktur der IONs und der Systemverbindung

zeigt;

-

4 ein

Blockschema der Elemente in einem JBOD-Gehäuse;

-

5 ein

Funktionsblockschema des physischen ION-Festplattentreibers;

-

6 ein

Schaubild, das die Struktur strukturspezifischer IDs zeigt;

-

7 ein

Funktionsblockschema, das die Beziehungen zwischen den ION-Gehäuseverwaltungsmodulen

und dem physischen ION-Festplattentreiber zeigt;

-

8 ein

Schaubild der hostseitigen BYNET-Schnittstelle;

-

9 ein

Schaubild des PIT-Kopfteils;

-

10 ein Blockschema der Funktionsmodule des ION 212;

-

11 ein Schaubild, das das ION-Dipolprotokoll zeigt;

-

12 einen Ablaufplan von Betriebsschritten, die

verwendet werden, um einen Datenumfang von einem ION zu einem Computerknoten

zu kommunizieren; und

-

13 einen Ablaufplan von Betriebsschritten, die

verwendet werden, um eine global eindeutige Identifizierung für den Datenumfang

in der Ausführungsform

der vorliegenden Erfindung zu erzeugen.

-

ÜBERBLICK

-

1 ist

ein Überblick über die

Peer-to-Peer-Architektur einer Ausführungsform der vorliegenden

Erfindung. Diese Architektur umfasst eine oder mehrere Rechnerressourcen 102 und

eine oder mehrere Speicherressourcen 104, die mittels einer

oder mehrerer Verbindungsstrukturen 106 und einen oder

mehrere Kommunikationswege 108 kommunikativ an die Rechnerressourcen 102 gekoppelt

sind. Die Strukturen 106 stellen das Kommunikationsmedium

zwischen allen Knoten und allen Speichern bereit, wodurch ein einheitlicher Peer-Zugriff zwischen

den Rechnerressourcen 102 und den Speicherressourcen 104 umgesetzt

wird.

-

In

der in 1 gezeigten Architektur ist

der Speicher nicht mehr an einen einzigen Satz von Knoten gebunden,

wie es in derzeitigen knotenzentrierten Architekturen der Fall ist,

und ein beliebiger Knoten kann mit allen Speichern kommunizieren.

Dies steht im Gegensatz zu heutigen Mehrknotensystemen, in denen

die physische Systemtopologie die Kommunikation zwischen Speicher

und Knoten einschränkt,

und es waren oft unterschiedliche Topologien erforderlich, um den

unterschiedlichen Arbeitslasten zu entsprechen. Die in 1 gezeigte

Architektur ermöglicht

den Kommunikationsmustern der Anwendungssoftware, die Topologie

des Systems zu einem beliebigen gegebenen Zeitpunkt zu bestimmen,

indem sie eine einzige physische Architektur bereitstellt, die ein

breites Spektrum an Systemtopologien unterstützt und ungleichmäßiges Technologiewachstum

zusammenfasst. Die von der Struktur 106 bereitgestellte

Trennung ermöglicht

eine feine Staffelung für

jede der primären

Systemkomponenten.

-

2 stellt

eine detaillierte Beschreibung der Peer-to-Peer-Architektur der vorliegenden Erfindung dar.

Die Rechnerressourcen 102 sind durch einen oder mehrere

Rechnerknoten 200 definiert, wobei jeder mit einem oder

mehreren Prozessoren 216 eine oder mehrere Anwendungen 204 unter

der Steuerung eines Betriebssystems 202 umsetzt. Peripheriegeräte 208,

wie beispielsweise Bandlaufwerke, Drucker oder andere Netzwerke,

sind operativ an den Rechnerknoten 200 gekoppelt. Ebenfalls

operativ an den Rechnerknoten 200 gekoppelt sind lokale

Speichereinrichtungen 210, wie beispielsweise Festplattenlaufwerke,

die die spezifischen Informationen, wie beispielsweise die Befehle,

die das Betriebssystem 202, die Anwendungen 204 oder andere

Informationen umfassen, des Rechnerknotens 200 speichern.

Anwendungsbefehle können

gespeichert und/oder über

mehr als einen der Rechnerknoten 200 auf Art der verteilten

Verarbeitung ausgeführt

werden. In einer Ausführungsform

umfasst der Prozessor 216 einen serienmäßig produzierten, handelsüblich erhältlichen

Mehrzweckprozessor, wie beispielsweise den INTEL P6, und zugehörige Speicher-

und E/A-Elemente.

-

Die

Speicherressourcen 104 sind durch Cliquen 226 definiert,

wobei jede einen ersten E/A-Knoten bzw. ION (I/O node) 212 und

einen zweiten E/A-Knoten bzw. ION 214 enthält, von

denen jeder durch eine Systemverbindung 228 operativ an

jede der Verbindungsstrukturen 106 gekoppelt ist. Der erste

ION 212 und der zweite ION 214 sind operativ an

eine oder mehrere Speicherfestplatten 224 (als „just a

bunch of disks" (lediglich

ein Bündel

Festplatten) bzw. JBOD bekannt) gekoppelt, die einem JBOD-Gehäuse 222 zugeordnet

sind.

-

2 stellt

ein System mittlerer Größe mit einem

typischen Zwei-zu-Eins-Verhältnis

vom ION 212 zu den Rechnerknoten bildlich dar. Die Clique 226 der

vorliegenden Erfindung könnte

auch mit drei oder mehr IONs 214 oder, unter geringem Verlust

bei der Speicherknotenverfügbarkeit,

mit einem einzigen ION 212 umgesetzt werden. Die Besetzung

der Clique 226 ist eine reine Softwareangelegenheit, da

zwischen den IONs 212 keine geteilte Hardware vorliegt.

Paarweise IONs 212 können

als „Dipole" bezeichnet werden.

-

Die

vorliegende Erfindung umfasst des Weiteren eine Verwaltungskomponente

bzw. einen Systemadministrator 230, der mit den Rechnerknoten 200,

den IONs 212 und den Verbindungsstrukturen 106 verbunden ist.

-

Die

Konnektivität

zwischen den IONs 212 und den JBODs 222 ist hier

in vereinfachter Form gezeigt. Die tatsächliche Konnektivität setzt

Fibre Channel-Kabel zu jeder der Ebenen (Reihen; hier vier Reihen)

der Speicherfestplatten 224 in der dargestellten Konfiguration

ein. In der Praxis ist es wahrscheinlich, dass jeder ION 212 zwischen

vierzig und achtzig Festplatten 224 anstelle der in der

dargestellten Ausführungsform

gezeigten zwanzig verwalten würde.

-

ION (Speicherknoten)

-

Interne Architektur

-

Hardwarearchitektur

-

3 ist

ein Schaubild, das weitere Einzelheiten in Bezug auf die Konfiguration

des ION 212 und dessen Schnittstelle mit den JBODs 222 zeigt.

Jeder ION 212 umfasst ein E/A-Verbindungsmodul 302 zum kommunikativen

Koppeln mit jeder Speicherplatte 224 in der Anordnung der

JBOD 222 mittels einer JBOD-Verbindung 206, eine

CPU mit Speicher 304 zum Durchführen der Funktionen des ION 212 und

Umsetzen der hierin beschriebenen physischen ION-Festplattentreiber 500 und

ein Energiemodul 306 zum Liefern von Energie, um den Betrieb

des ION 212 zu unterstützen.

-

JBODs

-

4 ist

ein Schaubild, das weitere Einzelheiten in Bezug auf das JBOD-Gehäuse 222 zeigt.

Alle Komponenten in einem JBOD-Gehäuse 222, die überwacht

oder gesteuert werden können,

werden Elemente 402 – 424 benannt.

Alle Elemente 402 – 424 eines

gegebenen JBOD-Gehäuses

werden durch einen Befehl Diagnoseergebnisse empfangen mit dem Konfigurationsseitencode

zurückgeleitet.

Der ION 212 verwendet diese Liste von Elementen zum Nummerieren

der Elemente. Das erste beschriebene Element 402 ist Element 0,

das zweite Element 404 ist Element 1, usw. Diese Elementnummern

werden beim Erstellen von LUN_Cs verwendet, die von der hierin beschriebenen

Verwaltungsdienstschicht 706 zum Ansteuern von Komponenten verwendet

werden.

-

-

Innerhalb

des Gehäuses

ist die Lage des Elements durch die Ebenen-, die Unterbau- und die

Elementnummer, wie in der obigen Tabelle I gezeigt, spezifiziert.

Ebenennummer ist eine interne Nummer des Dipols, die einer Ebene

zugeordnet ist, die zum Dipol gehört. Unterbauposition bezieht

sich auf die von den Zellenverwaltungseinrichtungen berichtete Höhe. Die

Elementnummer ist ein Index, der durch die SES-Konfigurationsseite in die Elementliste

zurückgeleitet

wurde. Diese Felder machen das LUN_C-Format aus.

-

E/A-Schnittstellentreiberarchitektur

-

5 ist

ein Schaubild, das die E/A-Architektur des ION 212 zeigt,

einschließlich

des physischen ION-Festplattentreibers 500, der für den ION 212 als

ein „SCSI-Treiber" agiert. Der physische

ION-Festplattentreiber 500 zeichnet für das Annehmen von E/A-Anforderungen

von den RAID-Softwaretreibern

(RAID = redundant array of inexpensive disks, redundante Anordnung

preisgünstiger

Festplatten) oder den Verwaltungsdienstprogrammen im Systemadministrator 230 und

das Ausführen

der Anforderung auf einer Einrichtung auf der Einrichtungsseite

der JBOD-Verbindung 206 verantwortlich.

-

Der

physische Festplattentreiber 500 der vorliegenden Erfindung

enthält

drei Hauptkomponenten: einen High-Level-Treiber (high level driver, HLD) 502 und

einen Low-Level-Treiber.

Der HLD 502 umfasst einen gemeinsamen Abschnitt 503 und

einen einrichtungsspezifischen High-Level-Abschnitt 504 und

den Low-Level-Treiber 506. Der gemeinsame Abschnitt 502 und

der einrichtungsspezifische High-Level-Abschnitt 504 sind

vom Adapter unabhängig

und erfordern bei neuen Adaptertypen keine Modifizierung. Der Low-Level-Treiber

der Fibre Channel-Schnittstelle (Fibre Channel Interface, FCI) 506 unterstützt Fibre

Channel-Adapter und ist daher eher protokollspezifisch als adapterspezifisch.

-

Der

FCI-Low-Level-Treiber 506 übersetzt SCSI-Anforderungen

in FCP-Frames und bearbeitet gemeinsame Fibre Channel-Dienste wie Login

und Prozess-Login. An den FCI-Low-Level-Treiber 506 ist eine HIM-Schnittstelle

(HIM = hardware interface module, Hardwareschnittstellenmodul) 508,

die die Fibre Channel-Protokollhandhabung aus den adapterspezifischen

Routinen splittet, operativ gekoppelt. Eine ausführlichere Beschreibung der

vorhergehenden Komponenten wird im Folgenden dargestellt.

-

HIGH-LEVEL-TREIBER

-

Der

High-Level-Treiber (High Level Driver, HLD) 502 ist der

Eingangspunkt für

alle Anforderungen an den ION 212, gleich auf welche Einrichtungsart

zugegriffen wird. Wenn eine Einrichtung geöffnet wird, verknüpft der

HLD 502 Befehlsseiten mit der Einrichtung. Diese anbieterspezifischen

Befehlsseiten diktieren, wie ein SCSI-Befehlsdeskriptorblock für eine spezifische

SCSI-Funktion anzulegen ist. Befehlsseiten ermöglichen dem Treiber, Einrichtungen,

die bestimmte SCSI-Funktionen

anders als von den SCSI-Spezifikationen spezifiziert bearbeiten,

problemlos zu unterstützen.

-

GEMEINSAMER (NICHT EINRICHTUNGSSPEZIFISCHER)

ABSCHNITT

-

Der

gemeinsame Abschnitt des HLD 502 enthält die folgenden Eingangspunkte:

- • cs_init – Initialisieren

von Treiberstrukturen und Zuweisen von Ressourcen.

- • cs_open – Vorbereiten

einer Einrichtung zur Verwendung.

- • cs_close – Abschließen von

E/A und Entfernen einer Einrichtung vom Dienst.

- • cs_strategy – Blockieren

von Einrichtungs-Lese-/Schreibeintrag

(Buf_t-Schnittstelle).

- • cs_intr – Warten

eines Hardware-Interrupts.

-

Diese

Routinen führen

für alle

Einrichtungstypen dieselben Funktionen durch. Die meisten dieser

Routinen rufen einrichtungsspezifische Routinen auf, um etwaige

einrichtungsspezifische Anforderungen mittels einer durch den Einrichtungstyp

(Festplatte, Band, WORM, CD-ROM usw.) indizierten Umschalttabelle

zu bearbeiten.

-

Die

Funktion cs_open stellt sicher, dass die Einrichtung existiert und

für an

ihr durchzuführende E/A-Vorgänge bereit

ist. Im Gegensatz zu derzeitigen Systemarchitekturen erstellt der

gemeinsame Abschnitt 503 während der Initialisierung des

Betriebssystems (operating system, OS) keine Tabelle bekannter Einrichtungen.

Stattdessen ist der gemeinsame Abschnitt 503 des Treibers

selbstkonfigurierend: der gemeinsame Abschnitt 503 des

Treibers bestimmt den Zustand der Einrichtung während des anfänglichen Öffnens dieser Einrichtung.

Das ermöglicht

dem gemeinsamen Abschnitt 503 des Treibers, die Einrichtungen

zu „sehen", die nach der Initialisierungsphase

des OS 202 möglicherweise

auf online geschaltet worden sein könnten.

-

Während des

anfänglichen Öffnens werden

SCSI-Einrichtungen durch Liefern eines SCSI-Anfrage-Befehls an die

Zieleinrichtung mit einer Befehlsseite verknüpft. Wenn die Einrichtung positiv

antwortet, werden die Antwortdaten (die Informationen wie beispielsweise

die Anbieter-ID, Produkt-ID

und das Firmwareversionslevel enthalten) mit einer Tabelle bekannter

Einrichtungen innerhalb des SCSI-Konfigurationsmoduls 516 verglichen.

Wenn eine Übereinstimmung

festgestellt wird, wird die Einrichtung mit der in diesem Tabelleneintrag

spezifizierten Befehlsseite explizit verknüpft. Wenn keine Übereinstimmung

festgestellt wird, wird die Einrichtung mit einer auf dem Antwortdatenformat

basierenden generischen CCS-Befehlsseite (CCS = Common Command Set,

standardisierter Befehlssatz) oder einer SCSI-II-Befehlsseite implizit verknüpft.

-

Der

gemeinsame Abschnitt 503 des Treibers enthält vom Low-Level-Treiber 506 verwendete

Routinen und Befehlsseitenfunktionen zum Zuweisen von Ressourcen,

um eine DMA-Liste für

Scatter/Gather-Vorgänge zu

erstellen und einen SCSI-Vorgang

abzuschließen.

-

Alle

Routinen des FCI-Low-Level-Treibers 506 werden vom gemeinsamen

Abschnitt 503 des Treibers aufgerufen. Beim gemeinsamen

Abschnitt 503 des Treibers handelt es sich um die einzige

Schicht, die tatsächlich

einen SCSI-Vorgang durch Aufrufen der entsprechenden Routine des

Low-Level-Treibers

(low level driver, LLD) im Hardwareschnittstellenmodul (hardware

interface module, HIM) 508 initiiert, um die Hardware einzurichten

und den Vorgang zu starten. Es wird auch mittels einer durch eine

Treiber-ID, die während

der Konfiguration vom SCSI-Konfigurationsmodul 516 zugeordnet

wurde, indizierten Umschalttabelle auf die LLD-Routinen zugegriffen.

-

EINRICHTUNGSSPEZIFISCHER

ABSCHNITT

-

Die

Schnittstellen zwischen dem gemeinsamen Abschnitt 502 und

den einrichtungsspezifischen Routinen 504 sind den Schnittstellen

zum gemeinsamen Abschnitt ähnlich

und enthalten cssx_init-, csxx_open-, csxx_close- und csxx_strategy-Befehle.

Die Kennzeichnung „xx" zeigt den Speichereinrichtungstyp

(z. B. „dk" für Festplatte

(disk) oder „tp" für Band (tape))

an. Diese Routinen bearbeiten alle einrichtungsspezifischen Anforderungen.

Wenn es sich bei der Einrichtung beispielsweise um eine Festplatte

handelt, muss csdk_open die Aufteilungstabelleninformationen aus

einem spezifischen Bereich der Festplatte auslesen und csdk_strategy muss

die Aufteilungstabelleninformationen verwenden, um zu bestimmen,

ob ein Block tabu ist. (Aufteilungstabellen definieren das Mapping

von logischem zu physischem Festplattenblock für jede spezifische physische

Festplatte.)

-

HIGH-LEVEL-TREIBER-FEHLER/AUSFALLSICHERUNGSHANDHABUNG

-

Fehlerhandhabung

-

Wiederholungen

-

Das üblichste

Wiederherstellungsverfahren des HLD 502 geschieht durch

Wiederholen der fehlgeschlagenen E/As. Die Anzahl der Wiederholungen

für einen

gegebenen Befehlstyp ist durch die Befehlsseite spezifiziert. Da

beispielsweise ein Lese- oder Schreibbefehl als sehr wichtig erachtet

wird, können

dessen zugehörige

Befehlsseiten den Wiederholungszählwert

auf 3 einstellen. Ein Anfragebefehl ist nicht so wichtig, ständige Neuversuche

während

der Vorgänge

beim Hochfahren (Start of Day) könnten

jedoch das System verlangsamen, daher könnte sein Wiederholungszählwert Null

sein.

-

Wenn

eine Anforderung zum ersten Mal ausgegeben wird, wird ihr Wiederholungszählwert auf

Null eingestellt. Jedes Mal, wenn die Anforderung fehlschlägt und das

Wiederherstellungsschema eine Wiederholung durchführen wird,

wird der Wiederholungszählwert

erhöht.

Wenn der Wiederholungszählwert

größer als der

durch die Befehlsseite spezifizierte maximale Wiederholungszählwert ist,

ist die E/A fehlgeschlagen und eine Nachricht wird zum Anforderer

zurück übertragen.

Andernfalls wird sie erneut ausgegeben. Die einzige Ausnahme von

dieser Regel besteht für „Unit Attentions" (Einheitswarnungen),

bei denen es sich in der Regel um Ereignisbenachrichtigungen und

nicht um Fehler handelt. Wenn für

einen Befehl eine Unit Attention empfangen wird und sein Wiederholungsmaximum

auf Null oder Eins eingestellt ist, stellt der High-Level-Treiber 502 das

Wiederho lungsmaximum für

diese spezifische E/A auf 2. Dies hindert einen E/A daran, vorzeitig

aufgrund einer Unit Attention-Kondition

abgelehnt zu werden.

-

Eine

verzögerte

Wiederholung wird analog zum oben beschriebenen Wiederholungsschema

bearbeitet, mit der Ausnahme, dass die Wiederholung nicht eine spezifizierte

Zeitspanne lang in der Warteschlange ersetzt wird.

-

Fehlgeschlagene

Scsi_ops

-

Ein

an den FCI-Low-Level-Treiber 506 ausgegebener Scsi_op kann

aufgrund mehrerer Umstände fehlschlagen.

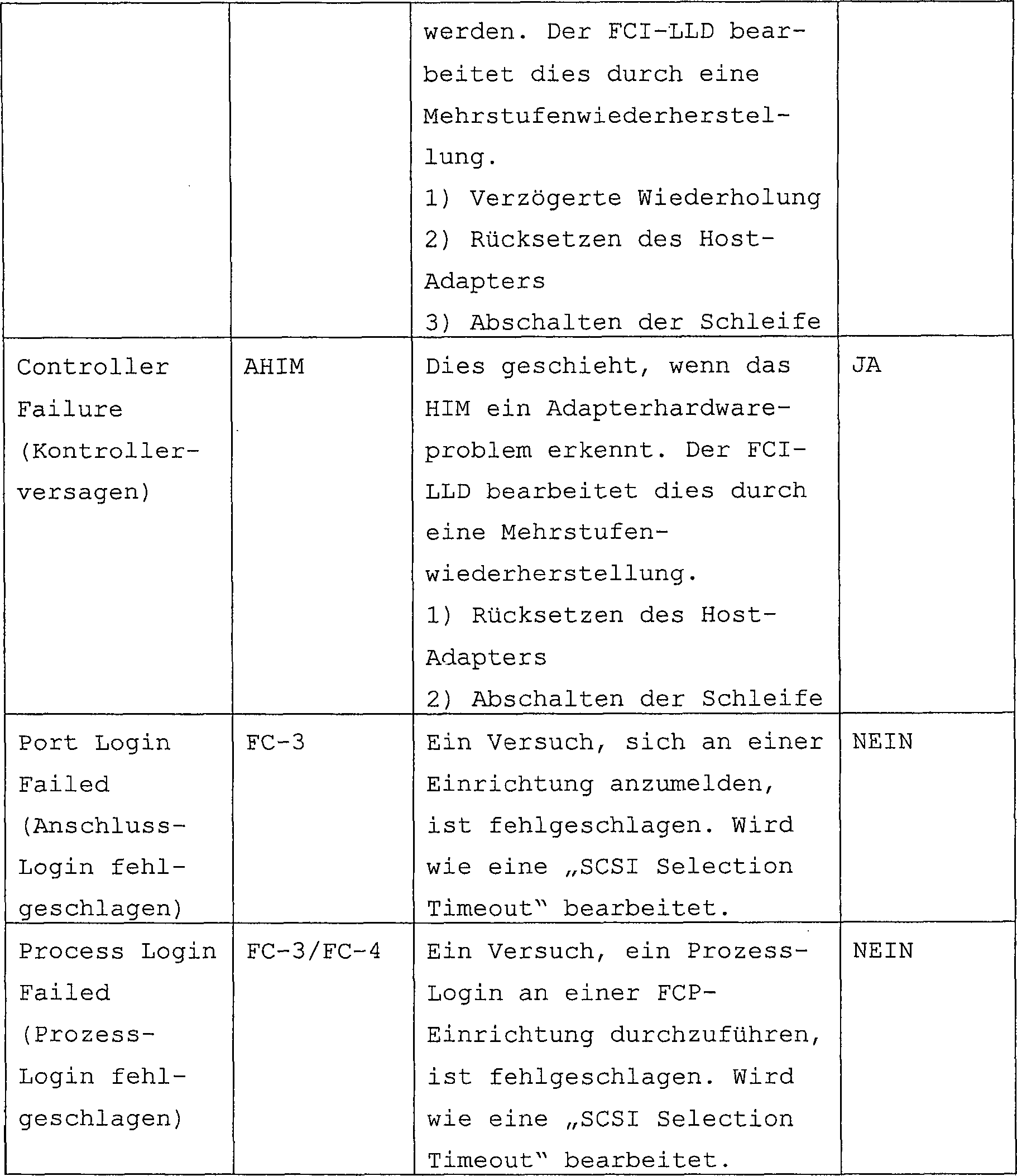

Die folgende Tabelle II zeigt mögliche

Fehlschlagstypen, die der FCI-Low-Level-Treiber 506 an den

HLD 402 zurückleiten

kann.

-

-

-

-

Tabelle

II: Fehlerkonditionen des Low-Level-Treibers

-

UNZUREICHENDE RESSOURCEN

-

Fehler

bezüglich

unzureichender Ressourcen treten auf, wenn eine beliebige gewünschte Ressource zur

angeforderten Zeit nicht zur Verfügung steht. In der Regel handelt

es sich bei diesen Ressourcen um den Systemspeicher und den Treiberstrukurspeicher.

-

Die

Handhabung von unzureichendem Systemspeicher wird durch Blockieren

von Semaphoren umgesetzt. Ein Thread, der auf einer Speicherressource

blockiert, wird verhindern, dass etwaige neue E/As ausgegeben werden.

Der Thread wird solange blockiert bleiben, bis der Abschluss einer

E/A Speicher freigibt.

-

Treiberstrukturressourcen

stehen mit den Listendatenbasen des Scsi_op und des E/A-Vektors

(I/O vector, IOV) in Zusammenhang. Die IOV-Liste ist eine Liste

von Speicherstart- und

Längenwerten,

die zu oder von der Festplatte übermittelt

werden. Diese Speicherdatenbasen werden beim Hochfahren (Start of

Day) durch Verwenden eines abstimmbaren Parameters initialisiert,

um den Umfang der Datenbasen zu spezifizieren. Wenn die Scsi_op-

oder die IOV-Datenbasis leer ist, wird eine neue E/A im Wachstum

dieser Datenbasen resultieren. Eine Speicherseite (4096 Byte) wird

zu einem Zeitpunkt zugewiesen, um eine der Datenbasen anwachsen

zu lassen. Die Seite wird nicht freigegeben, bevor nicht alle Scsi_ops

oder IOV von der neuen Seite freigegeben werden. Wenn ein ION 212 dauerhaft

Seiten für

Scsi_ops oder Seiten zuweist und freigibt, kann es wünschenswert

sein, die zugehörigen

Parameter abzustimmen.

-

Die

gesamte Handhabung von unzureichenden Ressourcen wird durch Ereignisse

protokolliert.

-

„START OF DAY"-HANDHABUNG

-

Beim

Hochfahren (Start of Day) initialisiert der HLD 502 seine

erforderlichen Strukturen und Datenbasen und führt Aufrufe aus, um adapterspezifische

Treiber und Hardware zu initialisieren. „Start of Day"-Handhabung wird

durch einen Aufruf von cs_init() gestartet, der (1) Scsi_op-Datenbasen

zuweist; (2) IOV-Datenbasen zuweist; (3) Aufrufe von FCIhw_init()

ausführt,

um Fibre Channel-Strukturen und -Hardware zu initialisieren; und

(4) die Interrupt-Dienstroutine

cs_intr() mit geeigneten Interrupt-Vektoren verknüpft.

-

AUSFALLSICHERUNGSHANDHABUNG

-

Die

zwei Hälften

des Dipols von ION 212 werden mit einem herkömmlichen

Satz von Festplatteneinrichtungen verbunden. Beide IONs 212 und 214 in

einem Dipol 226 müssen

zu einem beliebigen gegebenen Zeitpunkt in der Lage sein, auf alle

Einrichtungen zuzugreifen. Aus Perspektive des HLD 502 gibt

es keine spezielle Handhabung von Ausfallsicherungen.

-

BEFEHLSSEITEN

-

Die

IONs 212 der vorliegenden Erfindung verwenden ein Befehlsseitenverfahren,

das den gemeinsamen Abschnitt und die einrichtungsspezifischen Abschnitte

vom tatsächlichen

Anlegen des SCSI-Befehls absondert. Bei einer Befehlsseite handelt

es sich um eine Liste von Zeigern auf Funktionen, wobei jede Funktion einen

SCSI-Befehl (z. B. SCSI_2_Test_Unit_Ready) darstellt. Wie oben erwähnt wird

eine spezifische Befehlsseite beim anfänglichen Öffnen oder Zugriff auf eine

Einrichtung mit dieser Einrichtung verknüpft. Alle anbietereigenen und

nicht-konformen SCSI-Einrichtungseigenarten

werden durch die mittels der spezifischen Befehlsseite dieser Einrichtung

referenzierten Funktionen verwaltet. Ein typisches System würde mit

CCS-(command control

set, Befehlssteuersatz), SCSI I- und SCSI II-Seiten und anbietereigenen

Seiten geliefert werden, um eine Integrierung nicht-konformer SCSI-Einrichtungen

oder anbietereigener SCSI-Befehle zu ermöglichen.

-

Befehlsseitenfunktionen

werden von dem gemeinsamen Abschnitt 503 der Einrichtung,

dem einrichtungsspezifischen Abschnitt 504 und dem FCI-Low-Level-Treiber 506 (Request

Sense, Erfassung anfordern) durch eine als VirtualDEVice-Schnittstelle (VDEV-Schnittstelle)

bezeichnete Schnittstelle aufgerufen. In diesen Ebenen interessiert

es die Software nicht, welchen SCSI-Dialekt die Einrichtung verwendet,

sondern nur, dass die Einrichtung die geplante Funktion durchführt.

-

Jede

Befehlsseitenfunktion legt einen SCSI-Befehl an und weist gegebenenfalls

Speicher für

Datenübermittlungen

mit direktem Speicherzugriff (direct memory access, DMA) zu. Die

Funktion gibt dann die Steuerung zurück an den gemeinsamen Abschnitt 503 des

Treibers. Der gemeinsame Abschnitt 503 des Treibers führt anschließend den

Befehl aus, indem er den SCSI-Vorgang in eine Warteschlange setzt

(gegebenenfalls wird hier eine Sortierung vorgenommen) und ruft

die Start-Routine des FCI-Low-Level-Treibers 506 auf. Nachdem

der Befehl ausgeführt

wurde, wird, wenn in der Befehlsseitenfunktion eine „COI"-Routine (COI = Call

on Interrupt, Aufruf auf Interrupt) existiert, die COI aufgerufen,

bevor der gemeinsame Abschnitt 503 des Treibers die Daten/Informationen

des abgeschlossenen Befehls überprüft. Durch

Mitteilen der zurückgeleiteten

Daten/Infor-mationen kann die COI nicht-übereinstimmende SCSI-Daten/Informationen

in Standard-SCSI-Daten/Informationen umwandeln. Wenn bei spielsweise

die Anfragedaten einer Einrichtung, die in Byte 12 anstelle von

Byte 8 startende Anbieter-ID enthalten, wird die Befehlsseitenfunktion

für Anfrage

eine COI enthalten, die die Anbieter-ID in Byte 8 der zurückgeleiteten

Anfragedaten verschiebt. Der gemein-same Abschnitt 503 des

Treibers wird stets die bei Byte 8 beginnende Anbieter-ID-Information extrahieren

und benötigt

daher keine Informationen zur nicht-übereinstimmenden Einrichtung.

-

JBOD- UND

SCSI-KONFIGURATIONSMODUL

-

Eine

wichtige Funktion von RAID-Kontrollern besteht darin, Daten vor

Verlust zu sichern. Um diese Funktion durchzuführen, muss die RAID-Software

physisch wissen, wo sich eine Festplatteneinrichtung befindet und

auf welche Weise deren Verkabelung sich mit ihr verbindet. Daher

ist eine wichtige Voraussetzung beim Umsetzen von RAID-Kontrollertechniken

die Fähigkeit

zum Steuern der Konfiguration der Speichereinrichtungen. Der JBOD-Abschnitt

des JBOD- und SCSI-Konfigurationsmoduls 516 ist mit dem

Definieren einer statischen JBOD-Konfiguration für den ION 212 beschäftigt. Vom

JBOD- und SCSI-Konfigurationsmodul 516 beschriebene

Konfigurationsinformationen sind in Tabelle III gezeigt.

-

-

-

Zusätzlich zur

Information der physischen Lage der Adapter, des JBOD-Gehäuses 222 und

der Speicherplatten 224 müssen andere Konfigurationsinformationen

wie die Eingangspunkte des FCI-Low-Level-Treibers 506 und

des einrichtungsspezifischen Abschnitts 504 des Treibers

sowie Befehlsseitendefinitionen beschrieben sein. Zum Bereitstellen

dieser Informationen wird eine space.c-Datei verwendet und der ION 212 legt

die Konfigurationsinformationen bei der Kompilationszeit des physischen

ION-Festplattentreibers 500 an. In den Fällen, in

denen die unterstützten

Konfigurationen des ION 212 geändert werden, muss eine neue

Version der physischen ION-Festplattentreiber 500 kompiliert

werden.

-

LOW-LEVEL-TREIBER DER

FIBRE CHANNEL-SCHNITTSTELLE (FIBRE CHANNEL INTERFACE, FCI)

-

Der

FCI-Low-Level-Treiber 506 verwaltet die SCSI-Schnittstelle

für den

High-Level-Treiber 502. Die Schnittstelle zwischen dem

gemeinsamen Abschnitt 503 des Treibers und dem FCI-Low-Level-Treiber 506 beinhaltet

die folgenden Routinen, wobei es sich bei der Kennzeichnung „xx" um eine eindeutige

Kennung für

die Hardware, die der FCI-Low-Level-Treiber 506 steuert (z. B.

FCIhw_init), handelt:

- • xxhw_init – Initialisiert die Hardware.

- • xxhw_open – Bestimmt

den aktuellen Status des Host-Adapters.

- • xxhw_config – Einrichten

der Konfigurationsinformationen des Host-Adapters (SCSI-ID, usw.)

- • xxhw_start – Initiiert

einen SCSI-Vorgang, falls möglich.

- • xxhw_intr – Verarbeiten

aller SCSI-Interrupts.

-

Beim

Low-Level-Treiber handelt es sich in der Hinsicht um einen reinen

SCSI-Treiber, dass er weder von den Besonderheiten einer Einrichtung

weiß noch

dass ihn diese interessieren; er ist stattdessen einfach eine Leitung

für die

SCSI-Befehle vom oberen Level. Die Interrupt-Dienstroutinen, die

Hardwareinitialisierungs-, Mapping- und Adressübersetzungs- und die Fehlerwiederherstellungs-routinen

befinden sich in dieser Schicht. Darüber hinaus können mehrere

Arten von Low-Level-Treibern im selben System koexistieren. Diese Aufteilung

zwischen der hardwaresteuernden Schicht und dem Rest des Treibers

ermöglicht

es, dass auf verschiedenen Maschinen derselbe High-Level-Treiber

ausgeführt

werden kann.

-

Die

grundlegenden Funktionen des FCI-Moduls sind (1) sich mit dem SCSI-High-Level-Treiber

(SHLD) zu verbinden, um SCSI_ops in eine FCI-Arbeitsobjektstrukutr

(E/A-Block (I/O Block, IOB)) zu übersetzen;

(2) eine gemeinsame Schnittstelle bereitzustellen, um die Unterstützung der

neuen Fibre Channel-Adapter durch verschiedene HIMs 508 zu

vereinfachen; (3) gemeinsame FC-3-Dienste bereitzustellen, die von

einer beliebigen FC-4-Protokollschicht (in der dargestellten Ausführungsform

Fibre Channel-Protokoll (FCP)) verwendet werden kann; (4) Taktgeberdienste

bereitzustellen, um zum HIM gesendete asynchrone Befehle (z. B. FCP-Befehle, FC-3-Befehle,

LIP-Befehle) in dem Fall zu schützen,

dass das HIM 508 oder die Hardware nicht antwortet; (5)

Ressourcen für

den gesamten Fibre Channel-Treiber (FCI und HIM) zu verwalten, einschließlich (a)

E/A-Anforderungsblöcken

(IOB), (b) Vektortabellen, (c) Ressourcen des HIM 508 (z.

B. Host-Adapterspeicher, DMA-Kanäle,

E/A-Anschlüsse,

Scratch-Speicher); (6) für

die Verwendung einer Fibre Channel-„Arbitrated Loop" zu optimieren (im

Gegensatz zur Fibre Channel-Struktur).

-

Eine

Liste wichtiger Datenstrukturen für den FCI-Low-Level-Treiber 506 ist

in der folgenden Tabelle IV angegeben:

-

Tabelle

IV FC-Hauptdatenstrukturen

-

FEHLERHANDHABUNG

-

Fehler,

die der FCI-Low-Level-Treiber 506 bearbeitet, tendieren

dazu, in Bezug auf den Fibre Channel und/oder die FCI selbst fehlerspezifisch

zu sein.

-

MEHRSTUFENFEHLERHANDHABUNG

-

Der

FCI-Low-Level-Treiber 506 bearbeitet bestimmte Fehler mit

Mehrstufenhandhabung. Dies ermöglicht,

Fehlerhandhabungstechniken auf den Fehlertyp zu optimieren. Wenn

beispielsweise eine weniger destruktive Methode angewendet wird

und diese nicht funktioniert, können

drastischere Fehlerhandhabungsmaßnahmen unternommen werden.

-

FEHLGESCHLAGENE

IOB

-

Alle

E/A-Anforderungen werden durch einen E/A-Anforderungsblock zum HIM 508 gesendet.

Bei den folgenden Fehlern handelt es sich um mögliche Fehler, die das HIM 508 zurücksenden

kann.

-

-

-

Tabelle

V: HIM-Fehlerkonditionen

-

UNZUREICHENDE RESSOURCEN

-

Der

FCI-Low-Level-Treiber 506 verwaltet Ressourcendatenbasen

für IOB

und Vektortabellen. Da der Umfang dieser Datenbasen auf die Konfiguration

des ION 212 abgestimmt wird, sollte es nicht möglich sein, dass

diese Ressourcen ausgehen, und es werden einfache Wiederherstellungsmethoden

umgesetzt.

-

Wenn

eine Anforderung nach einem IOB oder einer Vektortabelle gemacht

wird und nicht genügend Ressourcen

vorliegen, um der Anforderung nachzukommen, wird die E/A wieder

in die Warteschlange gesetzt und ein Taktgeber wird zum erneuten

Starten der E/A eingestellt. Vorkommnisse mit unzureichenden Ressourcen

werden protokolliert.

-

„START OF DAY"-HANDHABUNG

-

Beim

Hochfahren (Start of Day) führt

der High-Level-Treiber 502 einen Aufruf an jeden unterstützten Low-Level-Treiber

(einschließlich

des FCI-Low-Level-Treibers 506) aus. Die „Start

of Day"-Handhabung

des Low-Level-Treibers der FCI 506 beginnt mit einem Aufruf

von der FCIhw_init()-Routine, die die folgenden Vorgänge ausführt.

-

Zunächst wird

für eine

spezifische PCI-Bus-Einrichtung eine HIM_FindController()-Funktion

aufgerufen. Dies ruft eine Version von FindController() auf. Das

JBOD- und SCSI-Konfigurationsmodul 516 spezifiziert die

zu durchsuchenden PCI-Bus-Einrichtungen.

Als Nächstes

wird, wenn ein Adapter (wie beispielsweise von ADAPTEC erhältliche)

gefunden wird, ein HCB zugewiesen und für den Adapter initialisiert.

Dann wird HIM_GetConfiguration() aufgerufen, um die adapterspezifischen

Ressourcen wie Scratch-Speicher, speicherabgebildete E/A und DMA-Kanäle zu erhalten.

Als Nächstes

werden Ressourcen zugewiesen und initialisiert und HIM_Initialize()

wird aufgerufen, um das HIM von ADAPTEC und die Hardware zu initialisieren.

Schließlich werden

IOB und Vektortabellen zugewiesen und initialisiert.

-

AUSFALLSICHERUNGSHANDHABUNG

-

Die

zwei Hälften

des Dipols von ION 212 werden mit einem herkömmlichen

Satz von Festplatteneinrichtungen verbunden. Beide IONs 212 müssen zu

einem beliebigen gegebenen Zeitpunkt in der Lage sein, auf alle

Einrichtungen zuzugreifen. Aus der Sichtweise des FCI-Low-Level-Treibers 506 gibt

es keine spezielle Handhabung von Ausfallsicherungen.

-

HARDWARESCHNITTSTELLENMODUL

(HARDWARE INTERFACE MODULE, HIM)

-

Das

Hardwareschnittstellenmodul (Hardware Interface Module, HIM) 508 ist

zum Verbinden mit dem SlimHIM 509 von ADAPTEC konzipiert.

Das HIM-Modul 508 hat als primäre Verantwortlichkeit, Anforderungen vom

FCI-Low-Level-Treiber 506 in eine Anforderung zu übersetzen,

die das SlimHIM 509 verstehen und zur Hardware ausgeben

kann. Dies umfasst das Annehmen von IOB-Anforderungen (IOB = I/O

Block, E/A-Block) und das Übersetzen

dieser in entsprechende TCB-Anforderungen (TCB = Transfer Control

Block, Übermittlungssteuerblock),

die vom SlimHIM 509 verstanden werden.

-

Die

grundlegenden Funktionen des HIM 508 beinhalten: (1) das

Definieren einer Low-Level-API (API = application program interface,

Anwendungsprogrammschnittstelle) zu hardwarespezifischen Funktionen,

die E/A finden, konfigurieren, initialisieren und zum Adapter senden

(Find, Configure, Initialize and Send), (2) das Verbinden mit dem

FCI-Low-Level-Treiber 506,

um E/A-Blöcke

(I/O Blocks, IOBs) in TCB-Anforderungen zu übersetzen, die das SlimHIM/die

Hardware verstehen kann (z. B. primitive FC-TCBs, FC-ELS-TCBs (ELS

= Extended Link Services, erweiterte Verknüpfungsdienste) und SCSI-FCP-Vorgangs-TCBs);

(3) das Verfolgen der Lieferung und des Abschlusses von an das SlimHIM

ausgegebenen Befehlen (TCB); (4) das Interpretieren von Interrupt-

und Ereignisinformationen vom SlimHIM 509 und Initiieren

der entsprechenden Interrupt-Handhabung und/oder Fehlerwiederherstellung

in Verbindung mit dem FCI-Low-Level-Treiber 506.

Die Datenstruktur des TCB ist in der folgenden Tabelle VI dargestellt.

-

Tabelle

VI: HIM-Hauptstrukturen

-

„START OF DAY"-HANDHABUNG

-

Das

HIM 508 definiert drei beim Hochfahren („Start

of Day") verwendete

Eingangspunkte. Der erste Eingangspunkt ist der HIM_FindAdapter,

der durch FCIhw_init() aufgerufen wird, und verwendet PCI-BIOS-Routinen,

um zu bestimmen, ob sich auf der gegebenen PCI-Bus-Einrichtung ein

Adapter befindet. Die PCI-Anbieter- und -Produkt-ID für den Adapter

wird verwendet, um zu bestimmen, ob der Adapter vorliegt.

-

Der

zweite Eingangspunkt ist der HIM_GetConfiguration, der durch FCIhw_init()

aufgerufen wird, wenn ein Adapter vorliegt, und setzt Ressourcenerfordernisse

in den bereitgestellten HCB. Beim ADAPTEC-Adapter beinhalten diese

Ressourcen IRQ-, Scratch- und TCB-Speicher. Diese Information wird

durch Ausführen

von Aufrufen an das SlimHIM 509 gefunden.

-

Der

dritte Eingangspunkt ist der HIM_Initialize, der durch FCIhw_init()

aufgerufen wird, nachdem Ressourcen zugewiesen und initialisiert

wurden, und die initalisierte TCB- Speicherdatenbasis ruft das SlimHIM auf,

um den Scratch-Speicher,

die TCB und die Hardware zu initialisieren.

-

AUSFALLSICHERUNGSHANDHABUNG

-

Die

zwei Hälften

des ION-Dipols 226 werden mit einem gemeinsamen Satz von

Festplatteneinrichtungen verbunden. Beide IONs 212, 214 müssen zu

einem beliebigen gegebenen Zeitpunkt in der Lage sein, auf alle

Einrichtungen zuzugreifen. Aus der Sichtweise des HIM 509 gibt

es keine spezielle Handhabung von Ausfallsicherungen.

-

AIC-1160-SlimHIM

-

Das

Modul SlimHIM 509 hat als Gesamtzielsetzung, eine Hardwareabziehung

des Adapters (in der dargestellten Ausführungsform der AIC-1160 von

ADAPTEC) bereitzustellen. Das SlimHIM 509 hat die primäre Rolle

des Transportierens von Fibre Channel-Anforderungen zum AIC-1160-Adapter,

des Bedienens von Interrupts und des Berichterstattens des Status

zurück

zum HIM-Modul durch die Schnittstelle des SlimHIM 509.

-

Das

SlimHIM 509 nimmt außerdem

die Steuerung der AIC-1160-Hardware

an sich und initialisiert diese, lädt die Firmware, startet Laufzeitvorgänge und übernimmt

die Steuerung der AIC-1160-Hardware beim Ereignis eines AIC-1160-Fehlers.

-

Externe Schnittstellen

und Protokolle

-

Alle

Anforderungen des physischen ION-Festplattentreiberteilsystems 500 werden

durch den gemeinsamen High-Level-Treiber 502 vorgenommen.

-

Initialisierung (cs_init)

-

Ein

einziger Aufruf in das Teilsystem führt die gesamte Initialisierung

durch, die für

das Vorbereiten einer Einrichtung auf E/As erforderlich ist. Während der

Initialisierung des Teilsystems werden alle Treiberstrukturen zugewiesen

und initialisiert sowie jegliche Einrichtungs- oder Adapterhardware

initialisiert.

-

Open/Close (cs_open/cs_close)

-

Die

Open/Close-Schnittstelle 510 initialisiert zum Zugriff

auf eine Einrichtung erforderliche Strukturen und analysiert diese.

Die Schnittstelle 510 ist typischen Open/-Close-Routinen unähnlich,

da alle „opens" (Öffnen) und „closes" (Schließen) implizit

geschichtet sind. Daraus folgernd muss jedes vom physischen E/A-Schnittstellentreiber 500 empfangene „open" von einem empfangenen

und zugehörigen „close" begleitet sein,

und einrichtungsbezogene Strukturen werden solange nicht freigegeben,

bis alle „opens" „geschlossen" (closed) wurden.

Die Open/Close-Schnittstellen 510 sind

insofern synchron, dass das Zurückleiten

des „open" oder des „close" den Abschluss der

Anforderung anzeigt.

-

Buf_t (cs_strategy)

-

Die

Buf_t-Schnittstelle 512 ermöglicht das Ausgeben von Lese-

und Schreibanforderungen des logischen Blocks an Einrichtungen.

Der Anforderer läuft

eine Buf_t-Struktur hinunter, die die E/A beschreibt. Attribute

wie die Einrichtungs-ID, die Adresse des logischen Blocks, die Datenadressen,

der E/A-Typ (Lesen/Schreiben) und die Rückrufroutinen werden durch

die Buf_t beschrieben. Nach Abschluss der Anforderung wird eine

durch den Rückruf

vom Anforderer spezifizierte Funktion aufgerufen. Die Buf_t-Schnittstelle 512 ist

eine asynchrone Schnittstelle. Das Zurückleiten der Funktion zum Anforderer

zeigt nicht an, dass die Anforderung abgeschlossen ist. Wenn die

Funktion zurückkommt,

kann die E/A auf der Einrichtung ausgeführt werden oder auch nicht.

Die Anforderung kann in einer Warteschlange darauf warten, ausgeführt zu werden.

Die Anforderung ist solange nicht abgeschlossen, bis die Rückruffunktion

aufgerufen wird.

-

SCSILib

-

SCSILib 514 stellt

eine Schnittstelle bereit, die es ermöglicht, SCSI-Befehlsdeskriptorblöcke (command

descriptor blocks, CDB) mit Ausnahme von normalen Lese- und Schreibvorgängen an

Einrichtungen zu senden. Durch diese Schnittstelle werden Anforderungen

wie Einheit Starten und Einheit Stoppen verwendet werden, um Festplatten

zu spulen und herunterzuspulen, und Sende- und Empfangen-Diagnosefunktionen werden

zum Überwachen

und Steuern von Gehäuseeinrichtungen

verwendet. Alle SCSILib-Routinen sind synchron. Das Zurückleiten

der aufgerufenen Funktion zeigt den Abschluss der Anforderung an.

-

Interrupts (cs_intr)

-

Der

physische ION-Festplattentreiber 500 ist der zentrale Versender

für alle

SCSI- und Fibre Channel-Adapterinterrupts. In einer Ausführungsform

wird ein Front-End/Back-End-Interruptschema

eingesetzt. In den Fällen,

in denen ein Interrupt bedient wird, wird eine Front-End-Interruptdienstroutine

aufgerufen. Das Front-End wird vom Interrupt-Stapelspeicher ausgeführt und

zeichnet verantwortlich für

das Leeren der Quelle des Interrupts, wobei der Adapter deaktiviert

wird, so dass er keine weiteren Interrupts erzeugen kann, und eine

Back-End-Interruptdienstroutine eingeplant wird. Das Back-End wird

als eine Aufgabe hoher Priorität

ausgeführt,

die den Interrupt (zusammen mit etwaigen anderen Interrupts, die

zwischen dem Deaktivieren der Adapterinterrupts und dem Starten

der Back-End-Aufgabe erfolgt sein könnten) tatsächlich bearbeitet. Vor dem Verlassen

des Back-Ends werden die Interrupts auf dem Adapter reaktiviert.

-

ION-Funktionen

-

Die

IONs 212 führen

fünf primäre Funktionen

durch. Diese Funktionen beinhalten:

Speicherbenennung und Projektion:

Koordiniert mit den Rechnerknoten 200, um eine einheitliche

und konsistente Benennung von Speicher bereitzustellen, indem Bilder

von auf den Speicherplatten 224 gespeicherten Speicherressourcenobjekten

zu den Rechnerknoten 200 projiziert werden;

Festplattenverwaltung:

Setzt Datenverteilungs- und Datenredundanztechniken mit den Speicherplattenlaufwerken 224,

die operativ an den ION 212 gekoppelt sind, um;

Speicherverwaltung:

Zur Handhabung der Speichereinrichtung, Datenbewegung, einschließlich der

Verarbeitung von E/A-Anforderungen

von den Rechnerknoten 200; Leistungsinstrumentation und

Ereignisverteilung.

Cache-Speicherverwaltung: Zum Lesen und

Schreiben von Daten-Cache-Speicherung, einschließlich von Cache-Speicher-Füllvorgängen, wie beispielsweise Anwendungs-Hint-Prefetch.

Verbindungsverwaltung:

Zum Steuern des Datenflusses zu und von den Rechnerknoten 200,

um die Leistung zu optimieren; steuert außerdem das Routing von Anforderungen

und somit die Verteilung von Speicher zwischen den zwei IONs 212 in

einem Dipol 226.

-

Speicherbenennung

und Projektion

-

Die

IONs 212 projizieren Bilder von auf den Speicherplatten 224 gespeicherten

Speicherressourcenobjekten zu den Rechnerknoten 200. Ein

wichtiger Teil dieser Funktion ist das Erstellen und Zuweisen von

global eindeutigen Namen, struktureindeutigen IDs oder Volumensatzkennungen

(volume set identifiers, VSIs) 602 für jede Speicherressource (einschließlich Festplatten

der virtuellen Struktur), die vom ION 212 verwaltet werden.

-

6 ist

ein Schaubild, das die Struktur und den Inhalt der VSI 602 und

zugehöriger

Daten zeigt. Da es wichtig ist, dass die VSIs 602 eindeutig

sind und nicht übereinstimmen,

zeichnet jeder ION 212 für das Erstellen und Zuweisen

von global eindeutigen Namen für

die Speicherressourcen, die lokal von jenem ION 212 verwaltet

werden, verantwortlich und nur dem ION 212, der die Speicherressource

verwaltet, die das Speicherressourcenobjekt speichert, ist es gestattet,

dieser Speicherressource eine VSI 602 zuzuweisen. Obwohl

nur der ION 212, der derzeit die residente Speicherressource

verwaltet, eine VSI 602 erstellen und zuweisen kann, können andere

IONs 212 danach das Speichern und Abrufen dieser Speicherressourcen

verwalten. Dies liegt daran, dass die VSI 602 für ein bestimmtes

Datenobjekt sich nicht ändern

muss, wenn eine durch einen ION zugeteilte VSI 602 später in eine

Speicherressource verschoben wird, die von einem anderen ION verwaltet wird.

-

Die

VSI 602 ist als eine 64-Bit-Zahl umgesetzt, die zwei Teile

beinhaltet: eine ION-Kennung 604 und eine Sequenznummer 506.

Die ION-Kennung 604 ist eine global eindeutige Identifikationsnummer,

die jedem ION 212 zugeteilt wird. Eine Technik zum Erhalten

einer global eindeutigen ION-Kennung 604 besteht

darin, die elektronisch lesbare Hauptplatinenseriennummer zu verwenden,

die häufig

im Echtzeittakt-Chip gespeichert ist. Diese Seriennummer ist eindeutig,

da sie nur einer Hauptplatine zugeteilt wurde. Da die ION-Kennung 604 eine

global eindeutige Nummer ist, kann jeder ION 212 eine Sequenznummer 606 zuordnen,

die nur lokal eindeutig ist, und trotzdem noch eine global eindeutige

VSI 602 erstellen. Eine weitere Technik, die die Zuordnung

einer global eindeutigen VSI garantiert, ist es, die Knoten-ID des

ION 212 zu verwenden, die beim Aufbooten für den global

eindeutigen ION-Identifizierer 604 erhalten wird. In ähnlicher

Weise kann, wenn multiple Systeme verbunden werden, eine System-ID,

die eindeutig den anderen bezogenen Systemen durch die AWS zugeordnet

ist, verwendet werden, um einen global eindeutigen ION-Identifizierer 604 zu

erzeugen.

-

Nachdem

die VSI 602 an eine Speicherressource auf dem ION 212 gebunden

wurde, exportiert der ION 212 die VSI 602 durch

eine Rundrufnachricht an alle Knoten auf der Struktur, um den Zugriff

auf die Speicherressource 104 zu ermöglichen. Dieser Prozess wird

hierin im Abschnitt zum ION-Namenexport

weiter erörtet.

-

Unter

Verwendung der exportierten VSI 602 erstellt die Software

des Rechnerknotens 200 dann einen lokalen Eingangspunkt

für diese

Speicherressource, der insofern semantisch transparent ist, als

dass er von einer beliebigen anderen, lokal angeschlossenen Speichereinrichtung

nicht zu unterscheiden ist. Wenn das Betriebssystem 202 des

Rechnerknotens beispielsweise UNIX wäre, werden sowohl der Eingangspunkt

der Blockeinrichtung als auch der der Roheinrichtung im Einrichtungsverzeichnis

analog zu einer lokal angeschlossenen Einrichtung, wie beispielsweise

den Peripheriegeräten 208 oder

den Festplatten 210, erstellt. Bei anderen Betriebssystemen 202 werden ähnliche

semantische Äquivalenzen

befolgt. Bei den unter den Rechnerknoten 200 laufenden,

verschiedenen Betriebssysteme 202 wird eine Stammnamenskonsistenz

beibehalten, um die heterogene Rechenumgebung am besten zu unterstützen. Lokale

Eingangspunkte in den Rechnerknoten 200 werden durch den

ION 212 dynamisch aktualisiert, um die derzeitige Verfügbarkeit

der exportierten Speicherressourcen 104 zu verfolgen. Die

VSI 602 wird von einem vom OS abhängigen Algorithmus verwendet,

der auf dem Rechnerknoten 200 läuft, um Einrichtungseingangspunktnamen

für importierte

Speicherressourcen zu erstellen. Dieser Ansatz gewährleistet

eine Namenskonsis tenz bei den Knoten, die sich ein gemeinsames Betriebssystem

teilen. Dies ermöglicht

dem System, eine Stammnamenskonsistenz beizubehalten, um durch dynamisches

(anstelle von statischem) Erstellen von lokalen Eingangspunkten

für global

benannte Speicherressourcen auf jedem Rechnerknoten 200 eine

heterogene Rechenumgebung zu unterstützen.

-

Wie

oben erörtert

werden die Einzelheiten des Erstellens der VSI 602 für die Speicherressource 104 direkt

von dem ION 212 gesteuert, der die Speicherressource 104 exportiert.

Um potentielle Unterschiede des Betriebssystems 202 unter

den Rechnerknoten 200 zu berücksichtigen, wird jeder VSI 602 ein

oder mehrere deskriptive Kopfteile zugeordnet, das/die mit der VSI 602 auf

dem ION 212 gespeichert wird/werden. Jeder Deskriptor 608 der

VSI 602 enthält

einen vom Betriebssystem (operating System, OS) abhängigen Datenabschnitt 610 zum

Speichern von genügend

vom OS 202 abhängigen

Daten, die für

das konsistente (sowohl der Name als auch die Betriebssemantik sind über die

Rechnerknoten 200 hinweg dieselben) Erstellen von Einrichtungseingangspunkten

auf den Rechnerknoten 200 für diese bestimmte VSI 602 erforderlich

sind. Diese vom OS abhängigen

Daten 610 enthalten beispielsweise lokale Zugriffsrechte

beschreibende Daten 612 und Besitzinformationen 614.

Nachdem eine VSI 602 durch den ION 212 errichtet

und vom Rechnerknoten 200 importiert wurde, jedoch bevor

der Eingangspunkt für

diese Speicherressource 104, die der VSI 602 zugeordnet

ist, erstellt werden kann, werden die entsprechenden OS-spezifischen

Daten 610 durch den ION 212 zum Rechnerknoten 200 gesendet.

Die mehreren deskriptiven Kopfteile ermöglichen über die VSI 602 sowohl

simultane Unterstützung

mehrerer Rechnerknoten 200, die unter verschiedenen Betriebssystemen

laufen (jedes OS hat seinen eigenen Deskriptorkopfteil) als auch

die Unterstützung

von disjunkten Zugriffsrechten unter verschiedenen Gruppen von Rechnerknoten 200.

Rechnerknoten 200, die sich denselben Deskriptorkopfteil

teilen, teilen sich ein gemeinsames und konsistentes Erstellen von

Ein richtungseingangspunkten. Somit können sowohl der Name als auch

die Betriebssemantik auf allen Rechnerknoten 200, die sich

einen gemeinsamen Satz von Zugriffsrechten teilen, konsistent gehalten

werden.

-

Der

VSI-Deskriptor 608 umfasst außerdem ein Alias-Feld 616,

das zum Bieten eines von einem Menschen lesbaren Namens der VSI 602 auf

den Rechnerknoten 200 verwendet werden kann. Wenn der Alias

für die

VSI 1984 beispielsweise „soma" ist, wird der Rechnerknoten 200 sowohl

für 1984

als auch für „soma" Verzeichniseinträge aufweisen.

Da der VSI-Deskriptor 608 mit der VSI 602 auf

dem ION 212 gespeichert wird, werden auf jedem Rechnerknoten 200,

der die VSI 602 importiert, dieselben Aliasse und lokalen

Zugriffsrechte erscheinen.

-

Wie

oben beschrieben verwendet die vorliegende Erfindung einen für ein verteiltes

Zuweisungsschema geeigneten Benennungsansatz. Bei diesem Ansatz

werden Namen unter Befolgung eines Algorithmus, der globale Eindeutigkeit

gewährleistet,

lokal erzeugt. Obwohl Variationen davon einen lokal zentralisierten

Ansatz befolgen könnten,

verschieben die Anforderungen in Bezug auf Verfügbarkeit und Robustheit die

Gewichtung stark in Richtung eines rein verteilten Ansatzes. Unter

Verwendung des Vorhergehenden ist die vorliegende Erfindung in der

Lage, einen lokal ausgeführten

Algorithmus zu erstellen, der globale Eindeutigkeit gewährleistet.

-

Das

Erstellen eines global konsistenten Speichersystems erfordert mehr

Unterstützung

als einfaches Einhalten von Namenskonsistenz über die Rechnerknoten 200 hinweg.

Zusammen mit den Namen gehen die Sicherheitsprobleme einher, die

in der vorliegenden Erfindung zwei Formen annehmen. Erstens ist

das die Sicherheit der Schnittstelle zwischen den IONs 212 und

den Rechnerknoten 200; zweitens ist das die Sicherheit der

Speicherung aus dem Rechnerknoten 200 heraus.

-

Speicherauthentifizierung

und -autorisierung

-

Eine

Ressource der VSI 602 ist durch zwei verschiedene Mechanismen

geschützt,

die Authentifizierung und die Autorisierung. Wenn ein Rechnerknoten 200 vom

ION 212 authentifiziert wird, wird der VSI-Name zum Rechnerknoten 200 exportiert.

Eine exportierte VSI 602 erscheint auf dem Rechnerknoten 200 als

ein Einrichtungsname. Auf einem Rechnerknoten 200 laufende

Anwendungsthreads können

versuchen, Vorgänge auf

diesem Einrichtungsnamen durchzuführen. Die Zugriffsrechte des

Einrichtungseingangspunkts und der OS-Semantik der Rechnerknoten 200 bestimmt,

ob ein Anwendungsthread dazu autorisiert ist, eine beliebige gegebene

Autorisierung durchzuführen.

-

Dieser

Ansatz zur Autorisierung erweitert die Autorisierung des Rechnerknoten 200 auf

die Speicherressourcen 104, die an einem beliebigen Ort

angeordnet sind, auf den die Verbindungsstruktur 106 zugreifen kann.

Die vorliegende Erfindung unterscheidet sich jedoch insofern von

anderen Computerarchitekturen, dass die Speicherressourcen 104 in

der vorliegenden Erfindung nicht direkt von den Rechnerknoten 200 verwaltet werden.

Dieser Unterschied macht es unpraktisch, lokale Autorisierungsdaten

einfach mit Dateisystemeinheiten zu verbinden. Stattdessen verbindet

die vorliegende Erfindung die Autorisierungsstrategiedaten des Rechnerknotens 200 mit

der VSI 602 am ION 212 und verwendet einen Zweistufenansatz,

in dem sich der Rechnerknoten 200 und der ION 212 eine

Ebene gegenseitigen Vertrauens teilen. Ein ION 212 autorisiert

jeden Computerknoten 200 zum Zugriff auf eine spezifische

VSI 602, eine weitere Verfeinerung der Autorisierung eines

spezifischen Anwendungsthreads auf die durch die VSI bezeichneten

Daten liegt jedoch in der Verantwortung des Rechnerknotens 200.

Die Rechnerknoten 200 setzen dann die Autorisierungsstrategie

für die

Speichereinheiten 104 durch, indem sie die in den vom ION 212 gespeicherten

Autorisierungsmetadaten enthalte nen Strategien verwenden. Deshalb

müssen

die Rechnerknoten 200 dem ION 212 dahingehend

vertrauen, dass er die Metadaten bewahrt, und der ION 212 muss

dem Computerknoten 200 dahingehend vertrauen, dass dieser

die Autorisierung durchsetzt. Ein Vorteil dieses Ansatzes besteht

darin, dass er nicht erforderlich macht, dass der ION 212 Kenntnis

in Bezug darauf besitzt, wie die Metadaten zu interpretieren sind.

Somit ist der ION 212 von durchsetzender spezifischer Autorisierungssemantik

getrennt, die von verschiedenen Autorisierungssemantika auferlegt

wird, die vom von den Rechnerknoten 200 verwendeten verschiedenen

Betriebssystemen 202 auferlegt werden.

-

Alle

einer VSI 602 zugeordneten Daten (einschließlich der

Zugriffsrechte) werden auf dem ION 212 gespeichert, die

Belastung des Verwaltens des Inhalts der Zugriffsrechtsdaten wird

jedoch auf die Rechnerknoten 200 gelegt. Genauer ausgedrückt werden,

wenn die von einem ION 212 exportierte Liste der VSIs 602 an

einen Rechnerknoten 200 gesendet wird, dem jede VSI 602 zugeordnet

ist, alle OS-spezifischen Daten vom Rechnerknoten 200 benötigt, um

die lokale Autorisierung durchzusetzen. Einem unter UNIX laufenden

Rechnerknoten 200 beispielsweise würden der Name, der Gruppenname,

die Benutzer-ID und die Modusbits gesendet; Daten, die dazu ausreichen,

einen Einrichtungseingangsknoten in einem Dateisystem zu erstellen.

Alternative Namen für

eine für

diese Klasse von Rechnerknoten-Betriebssystemen 202 spezifische

(oder lediglich für

diesen Rechnerknoten 200 spezifische) VSI 602 sind

in jede VSI 602 eingebunden. Lokale OS-spezifische Befehle,

die die Zugriffsrechte einer Speichereinrichtung verändern, werden

von der Software des Rechnerknotens 200 erfasst und in

eine Nachricht umgewandelt, die an den ION 212 gesendet

wird. Diese Nachricht aktualisiert die für die OS-Version spezifischen

VSI-Zugriffsrechtsdaten.

Wenn diese Änderung

abgeschlossen wurde, überträgt der ION 212 die

Aktualisierung unter Verwendung dieses OS im System an alle Rechnerknoten 200.

-

Wenn

ein Rechnerknoten (compute node, CN) 200 online geschaltet

wird, übermittelt

er eine „Ich

bin hier"-Nachricht

an jeden ION 212. Diese Nachricht enthält eine digitale Signatur,

die den Rechnerknoten 200 identifiziert. Wenn der Rechnerknoten 200 dem

ION 212 bekannt ist (der ION 212 authentifiziert

den Rechnerknoten 200), exportiert der ION 212 jeden

VSI-Namen, für

den der Rechnerknoten 200 über Zugriffsrechte verfügt. Der

Rechnerknoten 200 verwendet diese Listen von Namen der

VSI 602 zum Errichten der lokalen Zugriffseingangspunkte

für den

Systemspeicher. Wenn eine im Rechnerknoten 200 laufende

Anwendung 204 zunächst

den lokalen Endpunkt referenziert, stellt der Rechnerknoten 200 eine

Anforderung an den ION 212, indem er eine Nachricht über die

Verbindungsstruktur 106 hinweg für die Beschreibungsdaten der

Zugriffsrechte für

diese VSI 602 übermittelt.

Die Anforderungsnachricht enthält

eine digitale Signatur für

den anfordernden Rechnerknoten 200. Der ION 212 empfängt die

Nachricht, verwendet die digitale Signatur zum Auffinden des passenden

Satzes von VSI-Zugriffsrechten, der als Antwort gesendet werden

soll, und übermittelt

diese Daten über

die Verbindungsstruktur 106 an den anfordernden Rechnerknoten 200.

Der ION 212 interpretiert die an den Rechnerknoten 200 gesendeten

Zugriffsrechte nicht, sendet jedoch einfach die Daten. Die Software

des Rechnerknotens 200 verwendet diese Daten, um den passenden

Satz von lokalen Zugriffsrechten mit dem lokalen Eingangspunkt für dieses

betreffende Speicherobjekt zu verbinden.

-

Ein

Satz von Rechnerknoten 200 kann sich denselben Satz von

Zugriffsrechten teilen, indem er entweder dieselbe digitale Signatur

verwendet oder den ION 212 mehrere digitale Signaturen

mit demselben Satz von Zugriffsrechten verbinden lässt. Die

vorliegende Erfindung verwendet die Authentifizierung sowohl zum Identifizieren

des Rechnerknotens 200 als auch zum Spezifizieren, welcher

Satz von lokalen Autorisierungsdaten zum Erstellen des lokalen Eingangspunkts

verwendet werden wird. Die Autorisierungsdaten werden nur dann zum

Rechnerknoten gezogen, wenn die VSI 602 zunächst durch

eine Anwendung referenziert wird. Dieses Modell des „Ziehens

bei Bedarf" vermeidet

die Kosten des Verschiebens großer

Mengen von Zugriffsrechtsmetadaten auf sehr großen Systemen beim Starten.

-

Wenn

ein Rechnerknoten 200 die Authentifizierung nicht besteht,

sendet der ION 212 eine Nachricht ohne Namen der VSI 602 zurück und es

wird ein Authentifizierung fehlgeschlagen-Flag gesetzt. Der Rechnerknoten 200 kann

schweigend ohne VSI-Einrichtungsnamen von diesem ION 212 fortfahren

und die fehlgeschlagene Authentifizierung je nach den Wünschen des

Systemadministrators melden. Selbst eine erfolgreiche Authentifizierung

kann natürlich

darin resultieren, dass keine Übertragung

von VSI-Einrichtungsnamen an den Rechnerknoten erfolgt.

-

Konfliktlösung beim

Starten

-

Wenn

ein ION 212 startet, versucht er, eine VSI 602 zur

Verbindungsstruktur 106 zu exportieren. In derartigen Fällen muss

die Datenintegrität

des Systems vor jeglicher Störung

durch den neuen ION 212 bewahrt werden. Um dies zu erreichen,

wird der neue ION 212 überprüft, bevor

ihm ermöglicht

wird, Speicher zu exportieren. Dies wird folgendermaßen umgesetzt:

Zunächst

untersucht der ION 212 seinen lokalen Speicher, um eine

Liste von VSI 602 zu erstellen, die er exportieren kann.

Die Metadaten der VSI 602 enthalten eine VSI-Erstellungs-

oder -Mutationsnummer. Die VSI-Mutationsnummer

wird jedes Mal erhöht,

wenn eine diese VSI 602 betreffende bedeutende Statusänderung

erfolgt (wie beispielsweise wenn eine VSI erfolgreich zu einem Netzwerk

exportiert wird). Alle Knoten, die bei der VSI-Konflikterkennung

eine Rolle spielen, einschließlich

der Rechnerknoten 200 und der ION 212, unterhalten

im Speicher eine Vorgeschichte von exportierten VSIs und deren Mutationsnummern.

Alle Knoten auf der Verbindungsstruktur 106 müssen exportierte

VSI 602 ständig

auf VSI-Konflikte überwachen.

Die VSI-Mutationsnummer wird anfangs (wenn das Speicherausmaß zum ersten

Mal erstellt wird) auf Null gesetzt. Die Mutationsnummer stellt

insofern eine Konfliktlösungsreferenz bereit,

dass von einer exportierten VSI 602 mit einer Mutationsnummer,

die niedriger ist als zum vorherigen Zeitpunkt, zu dem sie exportiert

wurde, angenommen wird, dass sie eine Hochstapler-VSI ist, selbst

wenn der der echten VSI 602 zugehörige ION 212 außer Dienst

ist. Eine an einen ION 212 angehängte Hochstapler-VSI 602 mit

einer höheren

Mutantennummer als die der echten VSI 602 zugehörigen Mutantennummer

wird als die echte VSI 512 erachtet, außer wenn bereits E/A auf der

echten VSI 602 durchgeführt

wurden. Ein neu in die Verbindungsstruktur 106 eingeführter ION 212 muss

eine Mutantennummer aufweisen, die mit 0 beginnt.

-

Nachdem

der ION 212 ankündigt

hat, dass er sich dem System anschließen möchte, übermittelt er seine Liste von

VSI 602 und der zugehörigen

Mutantennummern. Alle anderen IONs 212 und alle Rechnerknoten 200 erhalten

diese Liste und überprüfen dann

die Bonität

des ION 212, die Liste der VSI 602 zu exportieren.

-

Von

anderen IONs, die derzeit dieselbe VSI 602 exportieren,

wird angenommen, dass sie gültig

sind, und diese senden dem neuen ION 512 eine Nachricht,

die den Export der einen Konflikt verursachenden spezifischen einen

oder mehreren VSI verbietet. Wenn der neue ION 512 eine

Erstellungs- oder Mutationsnummer aufweist, die höher als

die derzeit im System verwendete ist (ein Ereignis, das im gewöhnlichen

Betrieb nicht auftreten sollte, da VSI global eindeutig sind), wird

dies vermerkt und dem Systemadministrator gemeldet, der die jeweils

erforderliche Maßnahme

ergreifen wird. Wenn keine Konflikte vorliegen, wird jeder ION 212 und

jeder Rechnerknoten 200 mit einem Fortfahrvotum antworten.

Wenn die Antworten von allen IONs 212 und allen Rech nerknoten 200 empfangen

worden sind, wird die Erstellungsnummer aller VSIs 602 der

neuen IONs 212, die keinen Konflikt verursachen, erhöht und dem

System zum Exportieren zur Verfügung

gestellt.

-

Wenn

ein Rechnerknoten 200 über

eine Anwendungsreferenz und Zugriff auf eine VSI 602 verfügt, wird

der Rechnerknoten 200 die aktuelle Erstellungsnummer lokal

verfolgen. Jedes Mal, wenn ein neuer ION 212 eine VSI 602 anpreist

(zu exportieren versucht), vergleicht der Rechnerknoten 200 die

von der VSI 602 angepriesene Erstellungsnummer mit der

lokal für

diese VSI 602 gespeicherten Erstellungsnummer. Wenn die Erstellungsnummern übereinstimmen,

wird der Rechnerknoten für

das Fortfahren stimmen. Wenn die Erstellungsnummern im Widerspruch

zueinander stehen (wie es beispielsweise der Fall wäre, wenn

eine ältere

Version der VSI online geschaltet worden ist), wird der Rechnerknoten 200 eine

Verbotsnachricht senden. Die Rechnerknoten 200, die Erstellungsnummern

aufweisen, die älter

als die vom neuen ION 212 angepriesene Erstellungsnummer

für diese

VSI 602 sind, würden

für das

Fortfahren stimmen und die lokale Version der Erstellungsnummer

für diese

VSI 602 aktualisieren. Die Rechnerknoten bewahren die Erstellungsnummer

zwischen Neustarts nicht, da das grundlegende Design so gestaltet

ist, dass das System über

die Verbindungsstruktur 106 hinweg stabil ist und alle

Neulinge, einschließlich

der Rechnerknoten 200 und der IONs 212, auf Konsistenz überprüft werden.

-

Das

erste Hochfahren kann einige Situationen hervorrufen, bei denen

die Namensraumstabilität

für die VSI 602 in

Frage gestellt sein könnte.

Dieses Problem wird dadurch adressiert, dass die IONs 212 zuerst

hochgefahren werden und ihnen ermöglicht wird, mit dem Lösen von

Namenskonflikten fortzufahren, bevor die Rechnerknoten 200 sich

ihnen anschließen

dürfen.

Veraltete Versionen der VSIs 602 (aus alten Daten auf Festplattenlaufwerken

und anderen degenerativen Konditionen) können dann mittels der Erstellungsnummer aufgelöst werden.

Solange keine Rechnerknoten 200 die VSI 602 verwenden,

kann einem Neuling mit einer höheren

Erstellungsnummer ermöglicht

werden, den aktuellen Exporteur einer spezifischen VSI 602 für ungültig zu

erklären.

-

NAMENSDIENST

-

ION-Namen-Export

-

Ein

ION 212 exportiert den Arbeitssatz der VSIs 602,

den er exklusiv besitzt, um den Zugriff auf den zugehörigen Speicher

zu ermöglichen.

Der von einem ION 212 exportierte Arbeitssatz von VSIs

wird durch Verhandlungen über

den Besitz der VSI mit dem Buddy-ION (dem anderen ION 212 im

Dipol 226, als 214 gekennzeichnet) dynamisch bestimmt

und sollte innerhalb aller mit der Verbindungsstruktur 106 kommunizierenden

Knoten global eindeutig sein. Bei dem Satz handelt es sich in der

Regel um den Standard- oder PRIMÄR-Satz der dem ION 212 zugeordneten

VSIs 602. Die VSI-Übergabe

für Dynamischen

Lastenausgleich und Ausnahmekonditionen, die den Ausfall des Buddy-ION 214 und

den Ausfall des E/A-Pfads beinhalten, kann darin resultieren, dass

der exportierte Satz der VSI 602 sich vom PRIMÄR-Satz unterscheidet.

-

Der

Arbeitssatz von VSI wird jedes Mal vom ION 212 mittels

einer Rundrufnachricht exportiert; wenn der Arbeitssatz sich ändert, um

die Rechnerknoten 200 mit der neuesten Konfiguration der

VSI 602 auszustatten. Ein Rechnerknoten 200 kann

auch einen ION 212 nach seinem Arbeitssatz der VSI 602 befragen.

Der E/A-Zugriff auf die VSIs 602 kann von den Rechnerknoten 200 initiiert

werden, nachdem der ION 212 in den Online-Status für die exportierten

VSIs 602 eintritt oder wiedereintritt. Wie zuvor beschrieben

kann einem ION 212 nicht gestattet sin, in den Online-Status

einzutreten, wenn in den exportierten VSIs 602 etwaige

Konflikte vorliegen. Die einem „Speicherbrocken" zugeordneten VSI 602 sollten

alle eindeutig sein; es besteht jedoch die Möglichkeit, dass Konflikte auftreten

können

(beispielsweise wenn die VSI aus einer eindeutigen ID aufgebaut

wurden, die der Hardware des ION 212 zugeordnet ist, und

eine vom ION 212 verwaltete Sequenznummer und die Hardware

des ION 212 physisch bewegt wurden), wobei mehrere Speicherbrocken

dieselbe VSI aufweisen können.

-

Nachdem

der Arbeitssatz exportiert worden ist, stellt der exportierende

ION 212 einen Konfliktüberprüfungstimer

(2 Sekunden) ein, bevor er in den Online-Status eintritt, um den

E/A-Zugriff auf die exportierten VSI 602 zu ermöglichen.

Der Konfliktüberprüfungstimer

versucht, den Importeuren genug Zeit zum Ausführen der Konflikt-überprüfungsverarbeitung

zu geben und den Exporteur über

Konflikte zu zu informieren; dies kann jedoch nicht gewährleistet

werden, außer

wenn der Timer auf einen sehr hohen Wert eingestellt wird. Daher muss

ein ION 212 von allen Knoten (den Rechnerknoten 200 und

den IONs 212) eine explizite Genehmigung erhalten, um sich

offiziell online zu schalten. Die Online-Rundrufnachricht wird von

allen Knoten synchron beantwortet und das Resultat wird fusioniert

und per Rundruf zurückgesendet.

Ein ION 212 tritt offiziell in den Online-Status ein, wenn

es sich bei der fusionierten Antwort um eine ACK handelt. Wenn dem

ION 212 nicht gestattet wird, sich online zu schalten,

kann nicht auf den neu exportierten Satz der VSIs 602 zugegriffen

werden. Der/die Knoten, der/die die NAK gesendet hat/haben, sendet/senden

anschließend

außerdem

eine VSI-Konflikt-Nachricht an den Exporteur, damit dieser den Konflikt

löst. Nachdem

der Konflikt gelöst

wurde, exportiert der ION 212 seinen angepassten Arbeitssatz

und versucht erneut, sich online zu schalten.

-

CN-NAMEN-IMPORT

-

Die

Rechnerknoten 200 zeichnen dafür verantwortlich, Maßnahmen

zum Importieren aller von allen IONs 212 exportierten VSIs 504 zu

ergreifen. Während

der Verarbeitung am Tagesanfang („Start of Day") fordert ein Rechnerknoten 200 von

allen online geschalteten IONs 212 VSIs 602 an,

die zuvor exportiert wurden, so dass er eine aktuelle Ansicht des

Namensraums erhalten kann. Von diesem Punkt an horcht ein Rechnerknoten 200 nach

Exporten von VSI 602.

-

Einer

VSI 602 zugeordnete Steuerinformationen sind in einem „vsnode" enthalten, der vom

ION 212 unterhalten wird. Der Teil des Rechnerknotens 200 des

vsnode enthält